Joanna Kokot

Telefon: +48 883 570 809

E-mail: j.kokot@pozycjonusz.pl

Zrozumienie tego jak działa Googlebot to klucz do osiągnięcia sukcesu podczas pozycjonowania stron. Bez odpowiedniego dostosowania technicznych parametrów wszystkie działania SEO mogą spalić na panewce. Jak roboty google wpływają na pozycjonowanie?

Na początku trzeba odpowiedzieć sobie na pytanie czym tak naprawdę jest bot? W wielkim uproszczeniu jest to program wykonujący zautomatyzowane zadania najczęściej na bardzo dużą skalę. W jednym z naszych poprzednich artykułów opisywaliśmy dokładnie jak algorytmy kształtują internet. Częścią każdego bota jest zestaw algorytmów, które opisują zasady ich działania. Z kolei we wpisie: „Co to jest Google?” pokrótce wyjaśnialiśmy wedle jakich reguł pracują roboty Google. Narzędzia, które determinują sposób funkcjonowania największej na świecie wyszukiwarki internetowej.

Obecnie bardzo popularne są tzw. chatboty, które mają za zadanie prowadzić automatycznie obsługę klienta online piszącego na danej stronie. Dzięki temu można uprościć proces kontaktu i w tej samej chwili odpowiadać na kilkaset wiadomości na raz.

Każda wyszukiwarka posiada własnego bota, który działa na swój własny sposób. W gruncie rzeczy jednak wszystkie z nich skupiają się przede wszystkim na wyszukiwaniu i katalogowaniu stron w internecie.

Googlebot przede wszystkim zdobywa informacje o miliardach stron jakie istnieją obecnie w internecie. Pierwszym etapem „podróży” robota jest śledzenie linków prowadzących do konkretnej strony. Przeszukując znane już sobie domeny Googlebot śledzi adresy URL prowadzące na zewnątrz. Sprawia to, że linki w gruncie rzeczy działają podobnie jak drogowskazy. Jeżeli w bardziej widocznym miejscu znajduje się dany adres URL tym łatwiej jest go „dostrzec” robotowi Google. Dlatego tak ważny jest link building. Im więcej widocznych drogowskazów posiada nasza strona, tym szybciej zostanie „odwiedzona” przez bota. Jakość i ilość linkowania sama w sobie traktowana jest przez robota Google jako jeden z czynników rankingowych podczas oceny wartości strony docelowej.

Oczywiście przy pomocy Google Search Console, możemy przesłać informacje o naszej stronie. Dzięki temu nawet jeżeli nie prowadzi do niej żaden link zewnętrzny i tak zostanie ona odwiedzona przez robota.

Jeżeli tworzenie stron www masz już za sobą, to następnie robot trafiając na naszą domenę, musi odczytać jaka treść się na niej znajduje. Dzięki temu może on ją odpowiednio sklasyfikować i wybrać słowa kluczowe, które będą wyświetlane w wynikach wyszukiwania. Proces ten Google określa jako indeksowanie. To do jakiej „szufladki” trafi strona zależy bezpośrednio od tego jaka jest jej zawartość. Dotyczy to też samego kodu źródłowego, który może czasami utrudniać „zrozumienie” tego co znajduje się pod danym adresem URL.

Warto zauważyć, że Google oficjalnie przyznaje, że ich bot oparty jest o technologię bazującą na przeglądarce Chrome w wersji o numerze 41. Jest więc to już dość przestarzała technologia, ponieważ jej premiera miała miejsce na początku 2015 roku. Sprawia to, że do tej pory w niektórych przypadkach robot Google ma problemy z prawidłowym „odczytaniem” kodu opartego o JavaScript. Jednak niedawno na jednej z konferencji dla developerów przedstawiciele Google zapowiedzieli, że silnik, na którym dotychczas oparte jest renderowanie stron, zostanie wkrótce zaktualizowany. Wkrótce będzie to już zawsze obecna wersja przeglądarki Chrome. Wówczas większość problemów, które wynikały z przedawnienia technologii „wyświetlania” stosowanej przez Googlebota powinna zostać rozwiązana.

Kiedy już strona zostanie poprawnie wyrenderowana przez bota, bada on dokładnie jej zawartość. Wciąż najważniejsze pod tym względem są teksty opublikowane pod danym adresem URL. Dlatego optymalizowanie treści pod kątem SEO jest takie ważne. Podczas analizy treści na stronie bot przegląda również obrazki stąd warto zadbać o dostosowanie plików graficznych do pozycjonowania.

Warto również pamiętać, że od marca tego roku zaczęła obowiązywać aktualizacja Mobile First Index. Dzięki niej priorytet w procesie indeksowania mają wersje mobilne strony. W praktyce oznacza to, że jeżeli jakaś strona jest niedostosowana do wyświetlania na telefonach i tabletach, to jej wartość dla Googlebota może być bardzo niska.

W świecie internetu, Google to potężny gracz, który przyciąga miliony użytkowników każdego dnia. Ale czy wiesz, że istnieje cała rodzina różnych robotów internetowych, które Google używa do przeglądania i indeksowania zawartości stron internetowych? Każdy z nich pomaga w kształtowaniu wyników wyszukiwania.

Jest to specjalna odmiana GoogleBota, która przegląda internet, koncentrując się na treściach zoptymalizowanych pod kątem urządzeń mobilnych. Dlaczego jest to ważne? Ponieważ coraz więcej osób korzysta z urządzeń mobilnych do przeglądania internetu, Google podąża za tą tendencją i preferuje strony responsywne i dostosowane do różnych rozmiarów ekranów. Dzięki MobileBotowi Google może ocenić, czy strona jest dostosowana do urządzeń mobilnych i uwzględnić to w rankingu wyników wyszukiwania.

Obrazy są ważną częścią zawartości internetowej, dlatego Google wykorzystuje ImageBota, aby skanować i indeksować obrazy na stronach internetowych. Dzięki temu użytkownicy mogą wyszukiwać obrazy na temat interesujących ich rzeczy, wydarzeń czy osób. Właściciele stron internetowych mogą również zoptymalizować swoje obrazy, dodając odpowiednie tagi i opisy, aby zostały lepiej zindeksowane przez ImageBota i wyświetlane w wynikach wyszukiwania obrazów.

Czy kiedykolwiek zastanawiałeś się, jak Google dostarcza aktualne informacje na swoim serwisie Google News? Odpowiedzią jest NewsBot! Jest to specjalny robot, który skanuje witryny informacyjne i indeksuje nowe artykuły oraz inne wiadomości z całego internetu. Dzięki NewsBotowi Google dostarcza użytkownikom najświeższe aktualności i wciąż aktualizowane treści z różnych źródeł.

Jeśli jesteś użytkownikiem AdSense, z pewnością spotkałeś się z AdSenseBotem. Jest to bot odpowiedzialny za przeglądanie stron zawierających reklamy Google AdSense. AdSenseBot analizuje zawartość witryny i dopasowuje reklamy do kontekstu, co pomaga reklamodawcom docierać do odpowiedniej grupy odbiorców, a właścicielom witryn zarabiać na reklamach.

Wraz z rosnącą popularnością treści wideo w sieci, Google opracował GoogleBota Video, aby przeszukiwać i indeksować filmy i treści wideo na stronach internetowych. Dzięki temu użytkownicy mogą łatwo odnajdywać filmy związane z ich zainteresowaniami, a twórcy treści mają większą szansę na dotarcie do szerszej widowni.

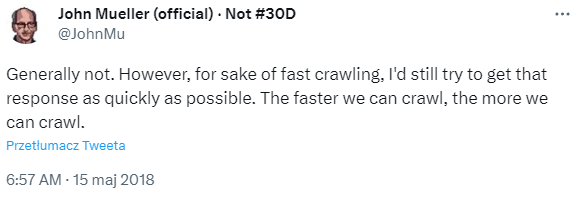

Warto pamiętać, że Googlebot nie ma nieograniczonych możliwości. Zazwyczaj podczas jednej „wizyty” jest w stanie odwiedzić tylko część podstron istniejących w obrębie konkretnej domeny. Ogólna ilość “zasobów” jakie są w stanie poświęcić roboty na analizowanie danej strony to tzw. crawl buget. Istnieje wiele czynników, które decydują o wielkości budżetu indeksowania. Jednym z nich jest chociażby prędkość ładowania strony. To, że czas ma bardzo duży wpływ na efektywność działania robotów potwierdził na twitterze John Mueller- jeden z głównych webmasterów Google:

W przypadku kiedy limit ten zostanie całkowicie wykorzystany, może dojść do sytuacji, w której niektóre adresy URL nie zostaną dodane do indeksu. Robotowi Google można ułatwić zadanie poprzez odpowiednie skonfigurowanie technicznych parametrów związanych ze stroną. Tego typu działania należą do fundamentów technicznego SEO. Do najważniejszych z nich należą:

Element służący do „kierowania” ruchem Googlebota to plik robots.txt. Umieszczany jest w głównym katalogu domeny. Zawiera on instrukcje dla wszystkich botów odwiedzających stronę. Np. jakie adresy mogą „odwiedzić”, a które są dla nich niedostępne. Dzięki temu można wykluczyć z indeksacji konkretne typy podstron. Takich jak na przykład koszyk zakupowy lub panel administracyjny. Należy tak robić, ponieważ z punktu widzenia bota nie zawierają one żadnych wartościowych informacji.

Istnieje również możliwość dodawania odpowiednich atrybutów przy umieszczaniu samych linków. Za pomocą rel=”nofollow” można określić, które linki robot powinien ominąć. Jednak nie jest to jednoznaczne z całkowitym wykluczeniem ich z procesu indeksowania. Żeby to zrobić należy użyć z kolei tagu <meta name=”robots” content=”noindex” />, który umieszcza się bezpośrednio w kodzie źródłowym strony, która nie powinna zostać dodana do indeksu Google, ponieważ blokuje to GoogleBot.

Bardzo istotne jest również to, aby zadbać o jak najmniejszą ilość wewnętrznych przekierowań 301. Także strony, które zwracają błąd 404 wpływają negatywnie na efektywność pracy Googlebota. Dlatego szczególnie ważne jest, aby dbać o to, by wszystkie linki prowadzące do strony jak i te wewnętrzne były zawsze aktualne. Dzięki temu nie będą marnowane zasoby robota przez co wartość strony nie zostanie obniżona.

Równie skutecznym sposobem na poprawienie sprawności pracy robota Google jest poprawne skonstruowanie mapy strony. Warto także dbać o to, aby była ona aktualizowana na bieżąco. W ten sposób Googlebot z łatwością powinien odnaleźć wszystkie adresy URL istniejące w ramach domeny i dodać je do indeksu.

Googlebot odgrywa kluczową rolę w pozycjonowaniu stron w wynikach wyszukiwania Google. Jego działanie ma istotny wpływ na widoczność i pozycję danej strony, przeglądając i indeksując zawartość, analizując treści, linki, słowa kluczowe i czas ładowania strony. Dodatkowo, bot zwraca uwagę na strony mobilne i analizuje zarówno wewnętrzne, jak i zewnętrzne linki prowadzące do danej strony. Aktualizacje algorytmów Google również wpływają na pozycjonowanie stron. Optymalizacja strony i współpraca z Googlebotem są kluczowe dla osiągnięcia lepszych pozycji w wynikach wyszukiwania.