Crawl Budget, nazywany również budżetem indeksowania witryny, określa liczbę stron, które robot Google jest w stanie zaindeksować w obrębie domeny. W przypadku gdy dana witryna posiada wiele podstron jej indeksowanie może zajmować więcej czasu. Można więc przyjąć w uproszczeniu, że crawl budget to ilość podstron jakie jest w stanie zaindeksować Googlebot podczas jednej wizyty.

W przypadku Google jednak nic nie jest tak proste jak mogłoby się wydawać na pierwszy rzut oka. Roboty indeksujące każdego dnia muszą przeskanować miliardy podstron. Każda taka wizyta bota na stronie zajmuje część zasobów serwera zarówno po stronie Google jak i właściciela danej domeny. Przy tak ogromnej liczbie podstron przeglądanych codziennie inżynierowie największej wyszukiwarki świata musieli wprowadzić pewne ograniczenia, które sprawiają, że efektywność działania Googlebota ma być jak największa przy jednoczesnym zmniejszeniu potrzebnej do tego mocy obliczeniowej. Dlatego prawidłowa optymalizacja strony pod kątem technicznego SEO jest jedną z podstaw działania w pozycjonowaniu.

Google wyszczególniło dwa główne parametry, które składają się na Crawl budget:

Kombincja obu tych wskaźników determinuje jak duży crawl budged otrzyma nasza strona. Idealnym rozwiązaniem jest kiedy zarówno limit współczynnika indeksacji jak i częstotliwość indeksacji są na równie wysokim poziomie. Żeby to osiągnąć musimy kontrolować zarówno parametry techniczne naszej strony jak i jej atrakcyjność w oczach potencjalnych użytkowników.

Roboty indeksujące Google starają się przejrzeć jak największą liczbę podstron w obrębie danej domeny. Z drugiej strony każda taka wizyta stanowi pewne obciążenie dla serwera. Dlatego też, aby nie zmniejszać wydajności witryny, co mogło by mieć negatywny wpływ na efektywność wyświetlania się strony dla potencjalnego użytkownika, zostały wprowadzone pewne ograniczenia. Crawl rate limit określa jak często konkretna domena jest indeksowana. Jest to stosunek liczby jednocześnie odwiedzanych podstron do czasu jaki upływa pomiędzy następującymi po sobie pobraniami przez Googlebota. Na częstotliwość pobierania wpływają następujące czynniki:

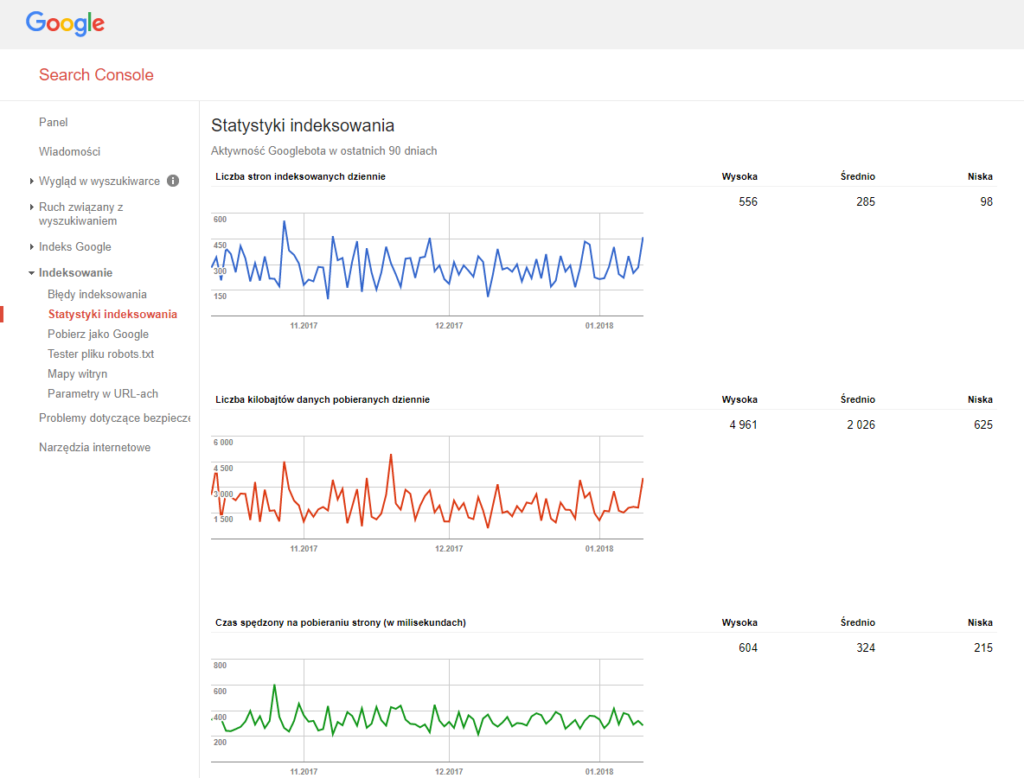

Dane dotyczące aktywności robota Google dostępne są w Search Console w sekcji statystyki indeksowania, która znajduje się w zakładce indeksowanie. Dzięki tym statystykom możemy określić jaki jest nasz budżet indeksacji.

Statystyki indeksowania są niezwykle pomocne przy diagnozowaniu wszelkich problemów związanych z budżetem indeksacji.

Liczba stron indeksowanych dziennie jest bezpośrednim odzwierciedleniem tego ile adresów URL w danej domenie zostało odwiedzonych przez Googlebota. Wskaźnik ten odzwierciedla poniekąd również jak bardzo przyjazna jest strona dla robotów indeksujących. Góry i doliny na wykresie są czymś całkowicie normalnym o ile występują regularnie. Natomiast jeżeli zauważymy nagły spadek ilości zaindeksowanych podstron będzie to wyraźny sygnał, że nasza witryna ma problemy i należy je zdiagnozować. Niestety nie mamy możliwości eksportowania danych z tego wykresu, ale jest szansa na to, że w nowej wersji Google Search Console może się to zmienić. Dobrym pomysłem jest monitorowanie i zapisywanie statystyk co kilka dni, aby mieć możliwość porównywania ich ze sobą w dłuższej perspektywie niż wyświetlane 90 dni.

Liczba kilobajtów danych pobieranych dziennie oznacza jak dużo kilobajtów zostało pobranych przez robota podczas wizyty. Wysokość tego wskaźnika jest uzależniona bezpośrednio od tego jak dużo danych znajduje się na stronie. Wysokie wartości w tym wykresie nie są niczym złym o ile nie powoduje to jednocześnie wydłużenia się czasu pobierania strony.

Czas spędzony na pobieraniu strony określa jak szybko Googlebot zbiera informacje. Wskaźnik ten powinien być zawsze utrzymywany na możliwie najniższym poziomie. Tak samo jak w przypadku użytkowników, tak i w przypadku robota wydłużony czas pobierania strony może zniechęcić do kolejnej wizyty.

Ten parametr można najprościej określić jako “popyt na indeksację”. Im strona ma większą wartość dla potencjalnego użytkownika tym chętniej będzie ona odwiedzana przez Googlebota. Nawet jeśli crawl rate limit nie został w pełni wykorzystany to strona może pomimo tego nie zostać zaindeksowana. Jeżeli nie istnieje “popyt na indeksację” to bot Google zmniejsza swoją aktywność na danej stronie. Na ten czynnik wpływ mają dwie cechy:

Budżet indeksowania witryny wprawdzie nie jest czynnikiem rankingującym, ale jego działanie ma bezpośredni wpływ na ilość podstron danej witryny, które będą widoczne w wynikach wyszukiwania Google. Dlatego też powinniśmy przykładać szczególną uwagę do tego, aby jak najlepiej zoptymalizować swoją stronę, zapewniając możliwie jak największą efektywność pracy Googlebota.

Crawl budget jest szczególnie istotny w przypadku domen, które posiadają bardzo dużo podstron jak na przykład sklepy internetowe. W takim wypadku ustalenie priorytetów tego co ma być crawlowane staje się jednym z najbardziej istotnych zadań dla każdego webmastera.

Marnotrawienie budżetu indeksowania na strony zawierające błędy może doprowadzić do tego, że aktywność Googlebota zmaleje w tych miejscach gdzie indeksowanie jest najbardziej potrzebne. W efekcie nowe podstrony będą pojawiały się w wynikach wyszukiwania z dużym opóźnieniem.